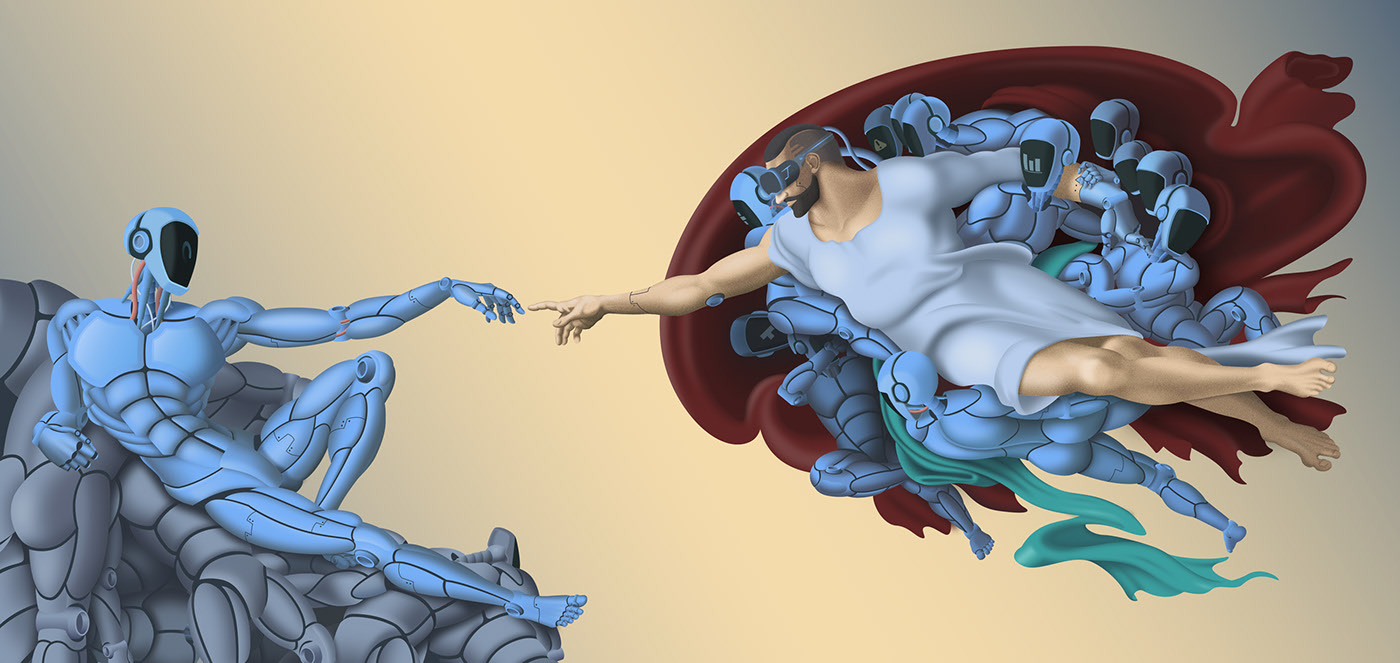

GPT-3

Generative Pre-trained Transformer 3 (Türkçe: Üretken Ön İşlemeli Dönüştürücü 3) kısaca GPT-3, insanların yazdığı metinlere benzer içerik üretmek için derin öğrenmeyi kullanan özbağlanımlı dil modelidir. GPT-n serisindeki üçüncü nesil dil tahmin modeli olan GPT-3, San Francisco merkezli yapay zeka araştırma laboratuvarı OpenAI tarafından geliştirilmiştir. GPT-3’ün tam sürümü, veri işleyecek 175 milyar parametreye sahiptir.

Bu rakam GPT-2’nin öğrenme kapasitesinin 2 katıdır. 14 Mayıs 2020’de tanıtılan ve Temmuz 2020 itibarıyla beta aşamasında olan GPT-3, önceden öğretilmiş dil örnekleriyle doğal dil işleme (NLP) sistemini kullanmaktadır. GPT-3’ün piyasaya sürülmesinden önce, en büyük dil modeli Microsoft’un Şubat 2020’de tanıttığı ve GPT-3’ün %10’undan daha az kapasiteye sahip olan (17 milyar parametre) Turing NLG idi.Wikipedia sitesinde bu şekilde açıklanıyor.

Youtube panelinde GPT-3 hakkında sorulan sorulara Google Brain’de Araştırmacı olan Lukasz Kaiser şu açıklamaları yaptı:

Transformerlardan öncesini yani derin öğrenme kısmında NLP’de RNN’ler her şeyi doğru yapıyordu. Derin öğrenmenin ve NLP’nin ilk büyük dalgasıydılar. İşleri adım adım yineleyerek yapmanız gerektiğine dair süper temel fikirlere sahiptiler, bu da çok sezgisel ancak modern donanımda gerçekten yavaştır çünkü hızlandırıcılar paralel işlem için inşa edilmiştir. Dikkat fikri NLP’de çok eski bir bir yöntem olan hizalamadan (alignment) geliyor. Diyelim ki bir cümleyi çevirmeye çalışıyorsunuz elinizde ingilizce ve fransızca cümleler var hangi kelimelerin hangi kelimelere karşılık geldiğini hizalamaya çalışıyorsunuz. Dolayısıyla, bu hizalama fikrini bir sinir ağına koyarsanız, elde ettiğiniz şey dikkat mekanizmasıdır. Kelimeleri daha önce gelen kelimelerle hizalamanın farklılaştırılabilir yumuşak bir versiyonudur ve öz-ilgi, aynı metni, daha önce görünen kelimelerle aynı hizaya getirecek şekilde hizalamaktır. Bu fikir, aldığınız sonuçlar açısından iyi işliyor, ancak aynı zamanda modern derin öğrenme hızlandırıcılarında iyi bir şekilde uygularsanız şaşırtıcı derecede hızlı da çalışıyor. Sonuçları bir gün veya bir ay beklemeniz gerekmiyor bu da büyük bir fark yaratıyor. Ama diğer bir şey de hizalama(alignment), nlp’de uzun zamandır bilinen gerçekten iyi bir fikir.

Paragrafın tamamını çevirmek istiyorsanız, bu bölümü çevirmeye odaklandığınızda ve her seferinde sadece bu bölüme baktığınızda çok daha kolay. Her insanın yaptığı da budur. Bunu bir sinir ağına öncelikli olarak veriyorsunuz ve bu gerçekten işe yarıyor, bu yüzden dikkatin geldiği yer burasıdır ancak şunu söylemek isterim, her şey dalgalar halinde ilerlerken, RNN’leri kullanmak çok iyi bir fikirdir. Çünkü seyrek transformatörlerle ilgili, bu ilginin insanların düşündüğünden daha çok RNN’ e benzediğini gösteren modern makaleler var ve aslında buna tekrar eden bir ağ(recurrent network) eklemek onu daha da iyi hale getiriyor. İnsanlar tekrar eden ağa geri dönerse, tekrar bir şekilde tekrarlayan ağlara bile dönüşmesi bu yüzden şaşırtıcı olmaz. En yeni teknikten daha fazlasını öğrenmek, daha önce gelen şeyleri bilmek ve bununla ilgili her şeyi öğrenmek iyidir.

Herkesin internette NLP’de derin öğrenme yaptığını düşünebilirsiniz ama ben bunun tam tersini düşünüyorum. Elbette bugünlerde her şey çevrimiçi olarak gerçekleşiyor, çok fazla hareket varmış gibi geliyor çünkü nlp dünyası onlarca yıl öncesine göre çok daha büyük ama bu derin modellerin aslında dil yapabildiği şeylerin yüzeyini zar zor çizdiğimizi hissediyorum. Bu dil son derece derin bir alandır. Evet, size bir hikaye oluşturabiliriz ve okuruz, tamam mıdır? Gerçekten anlamı var mı? Bu doğru şeyler yaratır mı? Bunu bize bildiğini söyleyebilir mi? Doğrulayabilir miyiz? Önyargılar(bias) hakkında konuştuğumuzu bildiğini bize söyleyebilir mi? Aslında dil modelinin bu kadar saldırgan olup olmadığını sorabilirsiniz ve çoğu durumda size bunun olup olmadığını söyleyecektir. Ancak insan benzeri olmayan bazı hatalar yapacaktır. Nedenini anlayabilir miyiz?

Sadece birkaç hafta önce piyasaya sürülen GPT-3, gradyan inişi olmadan öğrenebileceğini gösteren ilk model, bir şeyleri girdi olarak modele koyabilirsiniz ve sanki onları eğitiyormuş gibi çalışır, bu yüzden bu çok yeni ve test etmesi çok zor çünkü büyük modele ihtiyacınız var .

Yarım yıl veya yıl içinde, bunu uygulamalı olarak yapmaya başlayabileceğiniz modeller olacak. Öğrenmeye başlamak için harika bir zaman. Çünkü dile giren bu şeylerin çoğunun başlangıcı. Teknolojiyi aldık ama aslında dilin derinliklerine inerken hala önümüzde çok düşündüğümüz bu uygulamaları getirecek.

GPT-3 transformer modeli tüm web üzerinden eğitildi. Gelecekteki öğrenmeyi biraz beklenmedik olan yeni görevlere genelleştirir, ancak gerçekten tüm web üzerinde eğitilmiştir. Yani bir anlamda o kadar da beklenmedik değil ve arabalarda eğiteceğimiz daha küçük modelleri bile göreceksiniz, onlar da genelleştiriyorlar. Bu yüzden şimdi GPT-3 size harika cevaplar veriyor ama bu cevaplar ne işe yarıyor ve belki görevleriniz soruya uyuyor. Ancak görevinizi çözmeniz gerekir, genellikle görevinizi çözmek için modeli kullanmak ister ve onunla oynarsınız.

Tamam işe yaramaz bir görevi çözmelisin deneyim kazanıp, öğrenmen gerekiyor ama daha sonra gerçek dünya görevinde bir araç kullanmalısın ve harika çeviri modellerimiz var. Google Translate sadece bu model değil tam da bunun gibi derin öğrenme modeli başlatamazsın. Biraz regex eklemelisiniz. Korkunç bir çıktı üretip üretmediğini görmek için basit bir regexin için bile, tüm eski tekniklere ön işleme(pre-processing) koymanız gerekir. Kullanıcılarınıza, müşterilerinize sonuç olarak neyi çıkardığınıza bakmanız ve bunu doğrulamanız gerekir. Bu modelin neden belirli durumlarda kötü çıktılar verdiğini ve modeli nasıl tamir edeceğinizi bilmiyorsanız düşünmeye başlamanız gerekir.

Hala bilmediğimiz çok şey var, o zaman buna karşı biraz savunma yapmanız gerekiyor, belki sadece modelin gerçekten kötü olduğu ve GPT-3’ün kötü olduğu durumları tespit edin. GPT-3 diğer pek çok durumda iyidir, bu yüzden onu nasıl kullanacağınızı gerçekten öğrenmeniz gereken bir araç olduğunu öğrenmeniz gerekir. Verimli bir şekilde kullanabileceğiniz her yerde deneyim kazanın, sadece alıp uygulamak işe yarıyor mu? Hayır. Ne zaman çalıştığını, nasıl çalıştığını anlamak için çok iş var. Yıllar geçtikçe, bu şeylerin gerçekte nasıl çalıştığını daha iyi anlayacağımızı umuyoruz. Bunlar dilde biraz daha derine inmemize, ancak yine de uzun bir yol kat etmemize olanak tanıyan araçlar. Onu nerede nasıl kullanabileceğimizi öğrenmemiz gereken uzun bir yolumuz var ama bizim de ihtiyacımız olan başka şeyler olabilir ve kesinlikle bir GPT-4 olacaktır, bu yolun sonu değil, ama bu yolda büyük bir adım.

Bir diğer panelist olan makine öğrenmesi ve yapay zeka alanında verdiği eğitimlerle birçok insanın hayatına dokunan Prof. Andrew NG GPT-3 ün çıkışı hakkında şunları söyledi:

“İnanılmaz görünen her şey, çok çalıştığımızda ve bunları iyileştirdiğimizde, niş görünse bile doğru uygulamaları bulduğumuzda, bir gün okuduğumuz ve hayran kaldığımız bu modelin nerede olduğunu hayal edin. Kol saatinizde koşacak mıyım bilmiyorum ama teknoloji bu şekilde daha kullanılabilir hale geliyor. Şu anda NLP alanında çok sayıda zayıf sinyal görüyorum. Bunun patlayacağını ve daha yetenekli ve daha yaygın hale geleceğini düşündüğüm şeylerle yapabilirsiniz. Umarım bu araçları öğrenerek bu devrime katılabilirsiniz.”

GPT-3 parlak bir obje mi? Doğru zamanda mı piyasa sürüldü? İşlerimizi elimizden alacak mı?

Bu tür sorulardan ziyade kendimizi güncel tutmalı öğrenebileceğimiz herşeyi öğrenmeli, tüm yetkinlikleri kazanmalıyız. Bu yetkinlikleri bir sonraki ürünü geliştirmek için kullanmalıyız. Bu GPT4, GPT-5 yada adı her ne ise kendimizi geliştirip bu henüz yüzeyinde olduğumuz dünyanın derinlerine inmeliyiz. O dünyanın nasıl olacağını belirleyenler arasında olmalıyız.